6.1 Tecnologías Big Data (Hadoop, Spark, Hive, Rspark, Sparklyr)

A continuación se introducen los conceptos básicos de las tecnologías Big Data:

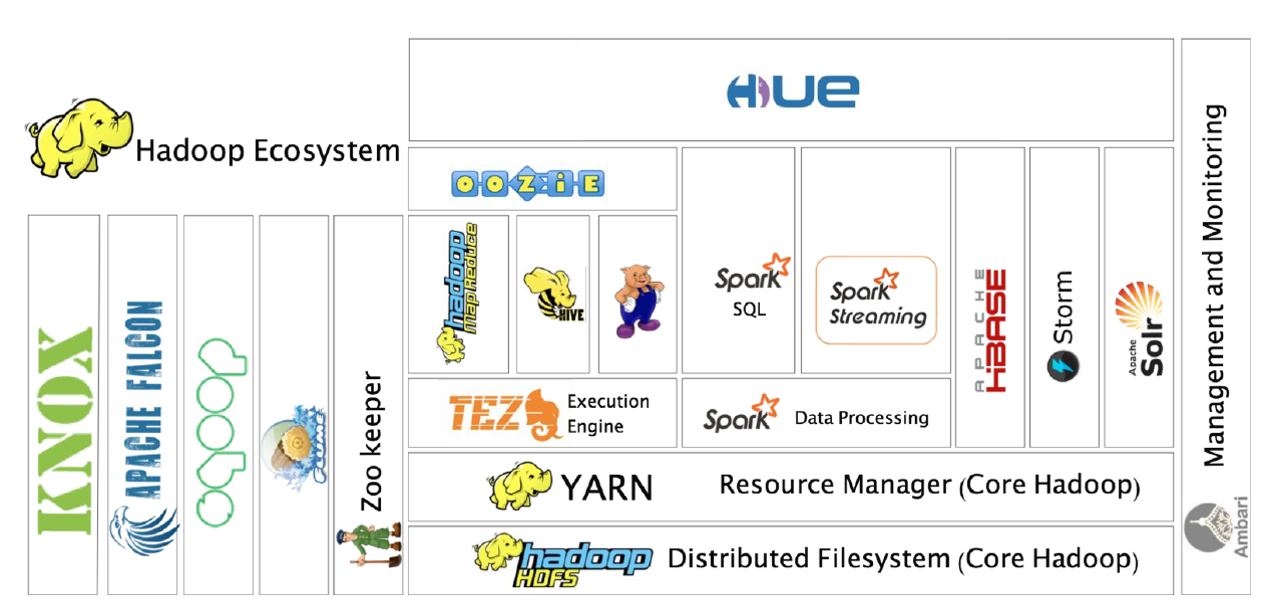

Hadoop: framework open-source desarrollado en Java principalmente que soporta aplicaciones distribuidas sobre miles de nodos y a escala Petabyte. Está inspierado en el diseño de las operaciones de MapReduce de Google y el Google File System (GFS). Entre sus principales componentes destaca HDFS Hadoop Distributed File System, sistema de ficheros distribuido sobre múltiples nodos y accesible a nivel de aplicación. También destaca YARN como gestor de recursos, para ejecutar aplicaciones. Destacar que la versión original, Hadoop 1, estaba basada extensivamente en Map Reduce, Hadoop 2 colocó en su core a YARN y Hadoop 3 está orientado a la provisión de Plataforma como servicio y ejecución simultánea de múltiples cargas de trabajo distribuidas sobre recursos solicitados bajo demanda.

Hive: es un sistema de almancenamiento y explotación de datos del estilo de un data warehouse open source diseñado para ser ejecutado en entornos Hadoop. Permite agrupar, consultar y analizar datos almacenados en Hadoop File System y en Amazon S3 (almacenamiento de objetos en general) en esquema en estrella. Su lenguaje de consulta de datos, Hive Query Language o (HQL).

Spark: framework de computación distribuida open-source para el procesamiento de datos masivos sobre Hadoop con un paralelismo implícito sobre su estructura de datos (Resilient Distributed Dataset o RDD), permite operar en paralelo sobre una colección de datos sin saber en qué servidores están disponibles dichos datos y de una forma tolerante a fallos. Es uno de los principales frameworks de programación de entornos Hadoop al estar optimizado su procesamiento sobre memoria (en lugar de sobre archivos en disco) para obtener velocidad, tanto en sus vertientes Spark streaming y Spark SQL, como Spark Machile Learning MLlib. Dispone de interfaces en Java, Scala, Python y R, siendo las interfaces de R Rspark y Sparklyr.

SparkR: es un paquete, el primero que apareció, para conectar R con Spark. Intenta ser lo más parecida a la interfaz estándard de R de manipulación de datos.

Sparklyr: es una librería para conectar R con Spark posterior a SparkR. Intenta ser lo más parecida a dplyr y embeber SQL en las consultas, soportando una mayor cantidad de paquetes. Por este motivo es el proyecto más activo actualmente, sustituyendo a SparkR.

6.1.1 Uso de Hadoop con dos ejemplos:

Conexión vía SSH a CESGA (siempre con VPN activada!) y ejemplo #1:

wget https://packages.revolutionanalytics.com/datasets/claims2.csv

# [3 minutos – 1GB/minuto en CESGA] [recomendada la descarga desde servidor dtn.srv.cesga.es] [copia temp /tmp]

hadoop fs –mkdir p1/

hadoop fs -mkdir p1/claims/

hadoop fs –put claims2.csv p1/claims/ [3 segundos]

hadoop fs –ls p1/claims/

$ myquota

# [1TB en $HOMEBD y 18TB en Hadoop]

$ spark-shell --packages com.databricks:spark-csv_2.10:1.4.0

> val sqlContext = new org.apache.spark.sql.SQLContext(sc);

> val df = sqlContext.read.format(csv).option(header, true).load(p1/claims/claims2.csv)

> df.count(); df.first(); df.take(5); df.printSchema();

> df.registerTempTable(TblName)

> sqlContext.sql(select * from TblName limit 100).take(100).foreach(println)

> sqlContext.sql(select * from TblName where Calendar_year=2005).count()Usando Spark-shell pero también podemos realizar ciertos análisis con hive:

$ hadoop fs -mkdir bdp

$ hadoop fs -mkdir bdp/hv_csv_table

$ hadoop fs -mkdir bdp/hv_csv_table/ip

$ hadoop fs -put claims2.csv bdp/hv_csv_table/ip

$ hive OR $ beeline (recomendado este último por seguridad pero por simplicidad usamos hive en CESGA)

CREATE SCHEMA IF NOT EXISTS bdp;

CREATE EXTERNAL TABLE IF NOT EXISTS bdp.hv_csv_table (Row_ID STRING, Household_ID STRING, Vehicle STRING, Calendar_Year STRING, Model_Year STRING, Blind_Make STRING, Blind_Model STRING, Blind_Submodel STRING, Cat1 STRING, Cat2 STRING, Cat3 STRING, Cat4 STRING, Cat5 STRING, Cat6 STRING, Cat7 STRING, Cat8 STRING, Cat9 STRING, Cat10 STRING, Cat11 STRING, Cat12 STRING, OrdCat STRING, Var1 STRING, Var2 STRING, Var3 STRING, Var4 STRING, Var5 STRING, Var6 STRING, Var7 STRING, Var8 STRING, NVCat STRING, NVVar1 STRING, NVVar2 STRING, NVVar3 STRING, NVVar4 STRING, Claim_Amount STRING, veh_age STRING) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE LOCATION 'hdfs://nameservice1/user/cursoXXX/p1/claims/';

SELECT * FROM bdp.hv_csv_table LIMIT 10;

SELECT * FROM bdp.hv_csv_table where Calendar_Year=2005 limit 10;

SELECT * FROM bdp.hv_csv_table where Calendar_Year>2005;Y ejemplo #2:

# Generación de un archivo spanishTexts-ALL y 120-million-word-spanish-corpus.zip

# Origen: https://www.kaggle.com/rtatman/120-million-word-spanish-corpus

hadoop fs –mkdir p2

hadoop fs -put 120-million-word-spanish-corpus.zip p2

$ spark-shell

# map

var map = sc.textFile(p2/spanishTest-ALL).flatMap(line => line.split( )).map(word => (word,1));

# reduce

var counts = map.reduceByKey(_ + _);

# save the output to file, every time a different directory!!!

counts.saveAsTextFile(p2/output)

counts.count() counts.first() counts.take(5)

# from word -> num to num -> word

# then sortBy num of occurrence in descending order

val mostCommon = counts.map(p => (p._2, p._1)).sortByKey(false, 1)

mostCommon.take(50)6.1.2 Uso de Sparklyr

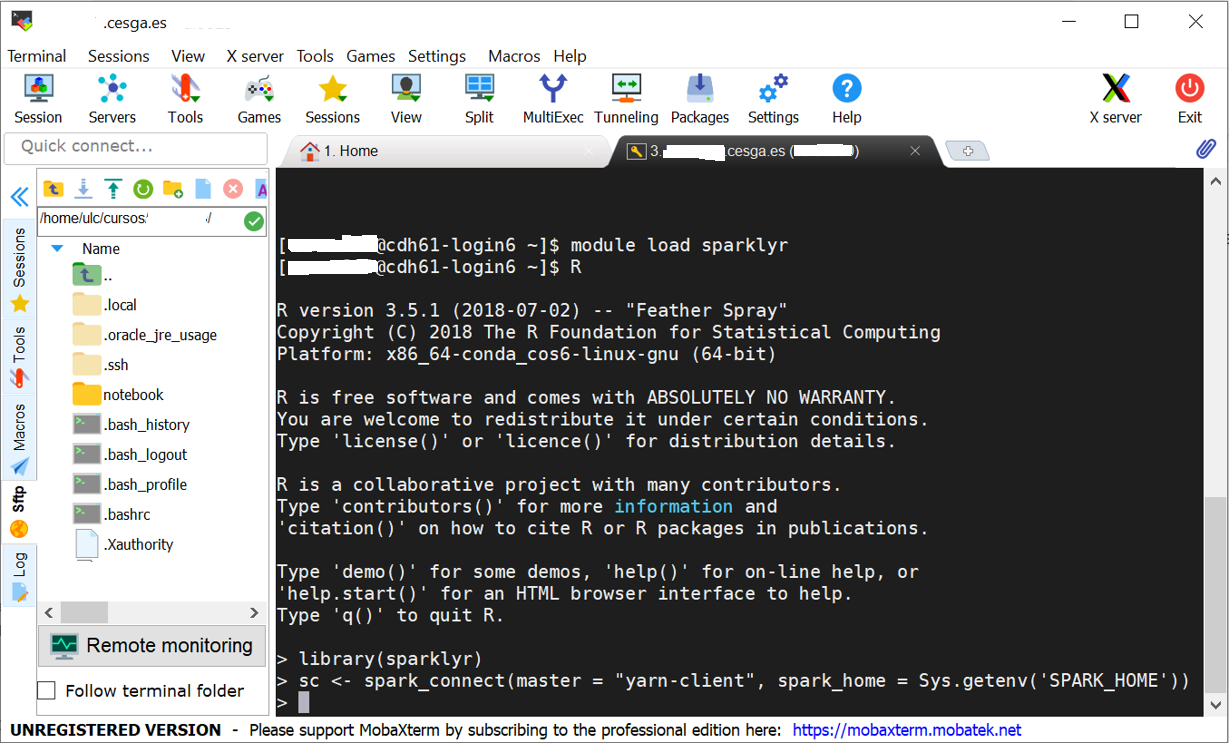

Conexión vía SSH a CESGA (siempre con VPN activada!) y una vez dentro “module load sparklyr” y arrancar R:

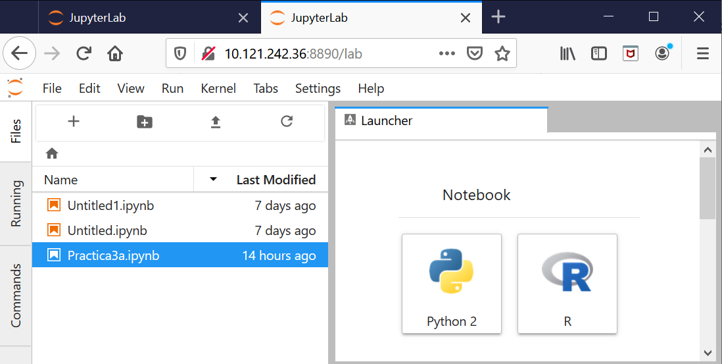

O alternativamente mediante jupyterlab. Para ello hacemos los dos primeros pasos del apartado anterior, conexión vía SSH a CESGA (siempre con VPN activada!) y una vez dentro “module load sparklyr”. Y a continuación escribimos “start-jupyter-lab” y nos conectamos a la URL indicada, desde la cual tendremos acceso a los notebooks Python/R:

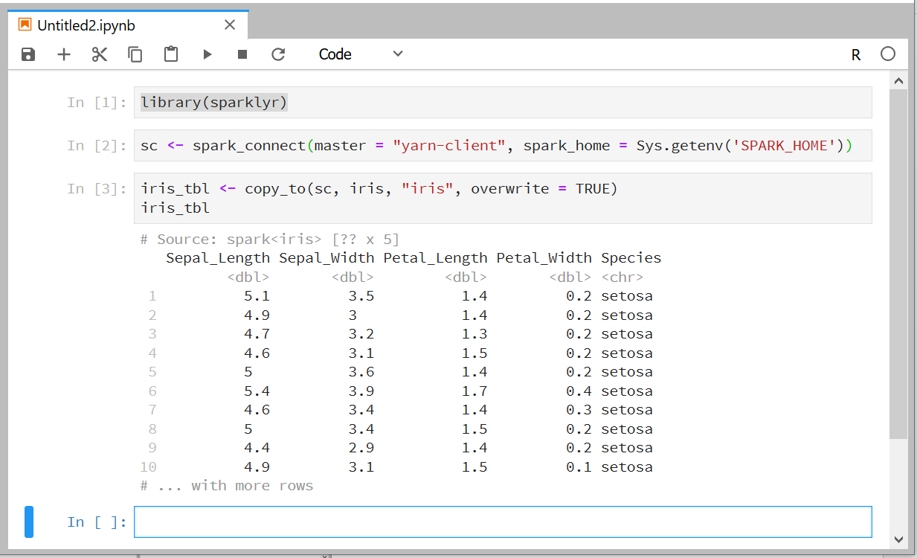

Y dentro del notebook R ya se puede probar el funcionamiento de Sparklyr con los siguientes pasos, cuyo resultado debería ser el que se aprecia a continuación:

library(sparklyr)

sc <- spark_connect(master = "yarn-client", spark_home = Sys.getenv('SPARK_HOME'))

iris_tbl <- copy_to(sc, iris, "iris", overwrite = TRUE)

iris_tbl

NOTA: en ausencia de clúster Hadoop con YARN, o para debugging, también se puede conectar usando las siguientes instrucciones, y obtener elm mismo resultado que en presencia de YARN.